A indústria de inteligência artificial, em constante evolução, enfrenta um dilema sobre a confiabilidade dos benchmarks de desempenho. Um novo modelo de inteligência artificial, Grok 3, lançado por xAI, provoca discussões sobre a eficácia desses testes para avaliar inovações tecnológicas.

O que é Grok 3 e suas inovações

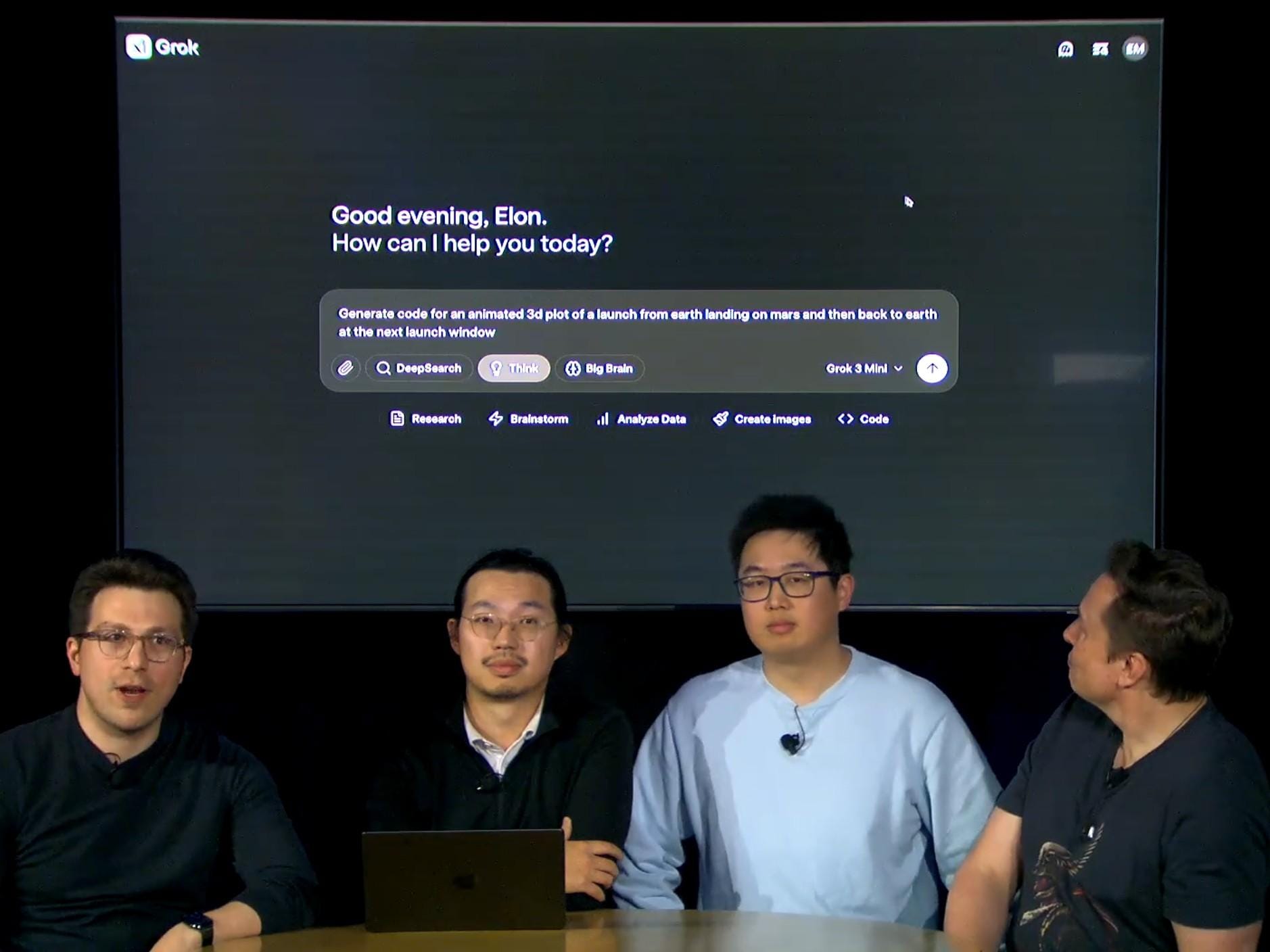

Grok 3, da startup xAI, despertou interesse com sua capacidade de superar outros modelos em questões de matemática e programação. Essa competição acirrada entre os gigantes da tecnologia mostra que o setor de IA não para de se reinventar. A treinamento de Grok 3 em 200 mil GPUs evidencia a ambição por inovações e melhorias contínuas.

A lacuna nos benchmarks atuais

A questão que muitos se perguntam agora é: será que os benchmarks atuais são suficientes? Professor Ethan Mollick ressaltou em postagens que esses testes muitas vezes falham em capturar a verdadeira eficácia dos modelos na vida real. Esses testes refletem mais um “sabor” do que uma medida exata da competência.

A controvérsia dos resultados

Além do mais, o fato de que muitas empresas de IA auto-relatam seus resultados cria um campo minado de desconfiança. Como confiar em números que podem ser manipulados? Se quisermos que a IA realmente mude nossas vidas, precisamos de testes independentes que verifiquem sua utilidade e impacto³, não é mesmo?

O futuro da avaliação em IA

Enquanto a indústria debate a relevância dos benchmarks, a necessidade de um novo conjunto de testes e modelos independentes se torna evidente. Alinhar os testes com resultados econômicos do mundo real pode ser o caminho. Afinal, o que importa mesmo é a aplicabilidade da IA em nossas vidas, não é? Ou será que as estatísticas da performance são tudo que realmente nos interessa?

O modelo SWE-Lancer

Recentemente, a OpenAI introduziu um novo benchmark, o SWE-Lancer, projetado para avaliar a capacidade de programação de sistemas de IA. Ele promete ser mais abrangente, abrangendo desde correção de bugs até propostas técnicas. Contudo, será que esse caminho é suficiente para resolver a questão dos benchmarks saturados? Mantendo o foco na eficácia, redefinindo o teste de IA pode nos levar a melhores resultados.

Esteja preparado para o que vem por aí

Com a agitação no mundo da IA, os especialistas já falam sobre o próximo grande avanço. Novos modelos surgem a passos largos, e talvez, como sugeriram alguns usuários nas redes sociais, seja mais saudável prestar menos atenção em cada lançamento, a não ser que se trate de uma inovação realmente significativa. Mensurar impacto e utilidade pode ser a chave para a nossa compreensão do que a IA pode fazer.

Conclusão

Com tantos modelos novos de IA aparecendo, é vital que a indústria comece a se concentrar não apenas em números e benchmarks, mas em como essas tecnologias realmente impactam nossas vidas. A conversação em torno de testes deve evoluir, refletindo não apenas a capacidade técnica, mas também a utilidade prática. O futuro da IA é brilhante, mas para realmente brilhar, precisamos de mais do que apenas números bonitos em relatórios.

**Resumo dos Principais Pontos:**

- Grok 3: O modelo da xAI eleito campeão em benchmarks, que levanta questões sobre a validade desses testes.

- Desafios de Benchmark: A discussão sobre a superficialidade dos benchmarks atuais e a necessidade de avaliações mais autênticas.

- Futuro e Novos Testes: A urgência de desenvolver novos modelos de avaliação que se alinhem ao impacto real da IA no mercado.